什么是馍?什么是型?什么是大馍型?AI大模型解惑

馍就是吃的馍馍

型就是很有型的人做馍馍

例如下图中的男馍

意思是一个很有型的男人在做馍

那么AI大模型又是啥玩意?

我们分开来说

AI是什么?

人工智能(Artificial Intelligence,简称AI)

是一门研究如何使计算机能够模拟和执行人类智能任务的科学和技术领域。

它致力于开发能够感知、理解、学习、推理、决策和与人类进行交互的智能系统。

人工智能的背景可以追溯到上世纪50年代,最初集中在基于规则的推理和专家系统的开发上。

随着计算机技术和算法的进步,尤其是机器学习和深度学习的兴起,人工智能开始迎来爆发式的发展。

大模型是什么?

大模型(Large Model),也称基础模型或Foundation Model,是指具有大量参数和复杂结构的机器学习模型。

它们能够处理海量数据、完成各种复杂的任务,如自然语言处理、计算机视觉、语音识别等。

大模型通过大量的数据和参数进行训练,以生成人类类似的文本或回答自然语言的问题。

超大模型是大模型的一个子集,它们的参数量远超过大模型。

大模型的种类

大模型按照输入数据类型和应用领域主要可以分为以下几类:

语言大模型(NLP):在自然语言处理领域中使用的大模型,如GPT系列、Bard、文心一言等。

视觉大模型(CV):在计算机视觉领域中使用的大模型,如VIT系列、文心UFO、华为盘古CV等。

多模态大模型:能够处理多种不同类型数据的大模型,如DALL-E、悟空画画等。

通用大模型 L0:可在多个领域和任务上通用的大模型,具有强大的泛化能力。

行业大模型 L1:针对特定行业或领域的大模型,相当于AI成为“行业专家”。

垂直大模型 L2:针对特定任务或场景的大模型,提高在该任务上的性能和效果。

适合本地部署的大模型及电脑配置要求

本地部署大型AI模型对电脑配置有一定要求,尤其是对GPU的显存和内存有较高需求。

以下是一些适合本地部署的大模型及基础配置推荐:

3B/7B/13B大模型:适合个人本地部署,对配置要求适中。

数字后面的B意思是10亿,3B则表示这个模型有大约30亿参数

一般推荐7B开始,小于7B的智商着急,大于7B的硬件资源消耗着急

我自己电脑4060 8gb显存,7B RWKV模型巨卡无比

CPU:10代I3或以上均可 AI时代的CPU就是打酱油的,可以理解为有个cpu就行

内存:16GB - 128GB,一般是显存的两倍左右。目前16gb远不能满足AI使用,基础配置建议32gb起步

我电脑32gb内存,转换7B模型时实际需要40gb内存,所以不要在说真的需要这么大内存吗,32gb已经是极低起步要求了硬盘:M.2 SSD 512GB 如今各种模型层出不穷,动不动十几GB甚至几十GB,磁盘不建议小于512,有条件的建议直接2TB起步

GPU:至少4060 16GB显存,若要微调则至少应该配置4090 24gb 这个显卡还不能做的全参微调,仅能够支持极为有限的微调

大模型的本地部署可以为研究人员和开发者提供强大的工具,但同时也带来了对硬件配置的挑战。

合理规划硬件资源、关注数据质量、保证系统稳定性是成功部署的关键。

随着技术的不断进步,未来可能会有更多高效且易于部署的大模型出现,进一步推动AI技术的发展和应用。

目前我自己常用的模型是Meta Liama3 中文量化版

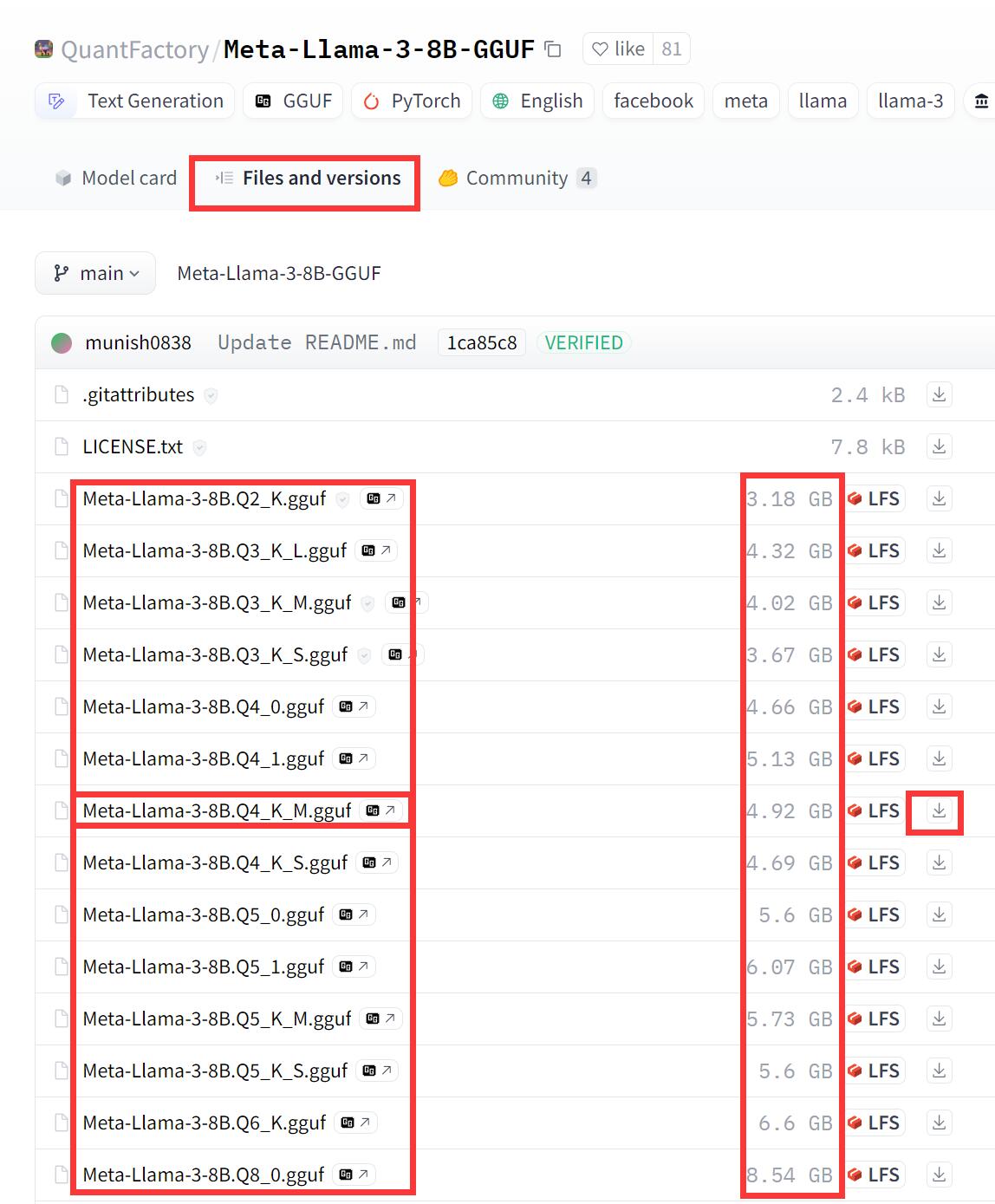

Llama-3-8B-Q4-K-M.gguf

模型参数 8B

量化参数 Q4-K-M

模型体积 4.8gb

显存消耗 6gb

每秒吐字 8-12 Tok/s

https://hf-mirror.com/ 模型可以在这个站点自己搜索

关键词加上gguf

https://hf-mirror.com/QuantFactory/Meta-Llama-3-8B-GGUF/tree/main

例如我下载的是这个

上图中框起来这么多,实际都是同一个模型

只是量化参数不一样

根据自己电脑配置下载

原则上模型体积越大,质量越好

但是体积越大,对资源要求越高

例如我电脑显卡8gb显存,除去系统占用1gb

下载5gb左右的最合适

再小,质量太低

再大,明显不流畅

例如我下载了llama3 70b

Q1量化版本,模型体积不到16gb

一样可以跑起来

两秒钟回答一个字

有毛线用吗

严重影响体验

以下是推荐加载gguf模型的工具,都是免环境配置,在windows上双击运行之类的

三个都是英文界面

LM Studio

koboldcpp

llamafile

另外在推荐一个国产的 RWKV

这个就是傻瓜式,有详细使用说明,中文,免费,开源

RWKV Runner https://github.com/josStorer/RWKV-Runner

或者同源的 ai00_server

https://github.com/Ai00-X/ai00_server

评论 (0)