搜索到

218

篇与

» 茶余饭后

的结果

-

中国游客7宗罪,全球最不受欢迎游客 中国游客7宗罪,全球最不受欢迎游客 ( [转载](https://baijiahao.baidu.com/s?id=1668567385573733394&wfr=spider&for=pc) )  上个月,《纽约时报》把中国游客列为"全球最不受欢迎游客"。 认为他们无论到哪里旅游都令人感到生厌,获得如此污名,原来说中国游客犯了七宗罪。 爱插队 不少中国游客多不爱排队,明明人人都在排队时,却有意无意插队。 沒文化 在欧洲旅游时,中国游客很多都不懂艺术,有些还像女性雕像前摆出不雅动作拍照。 高谈阔论 不少中国游客不理他人感受,何时何地都在高谈阔论。 怕吃亏 中国人怕吃亏,例如外游时坐公车,都会及时抢占座位。 自私 中国游客出外旅游,大多只顾自己感受,没有入乡随俗,不爱理会当地人的规矩。 到此一游 虽然自己不是名人,但都爱把自己名字写上名胜古迹处。 呕心行为 中国游客爱四处随地吐痰,随地大小便行为,非常不文明。 有游客在卢浮宫外泡脚。 转载2 [转载2 ](https://baijiahao.baidu.com/s?id=1615362296392771712&wfr=spider&for=pc) 为何如此讨厌中国游客?背后原因发人深省!网友:说的在理! 随着社会的发展,越来越多的人感慨生活节奏太快,压力太大活得很累。 在这种情况下,出去休闲放松一下就成了一个很好的解决方法。 在近些年里,中国的旅游业发展迅速,尤其是出国旅游的人数明显上升,中国游客由于各种原因在世界上“出名”了。 出名主要有两大原因。 第一,中国游客的人数基数大,购买力强,经常能带动当地经济的发展。 但同样的,由于形形色色什么样的人都有,游客的素质层次不齐,所以也就造成了一些国家地方对国人的印象很差,甚至有些警示标语采用中英两种翻译,目的是显而易见的。 经过一系列的事件以后,有一些国家在民间甚至都表示不愿意招待中国游客。 尽管他们能给当地带来很多经济收入,但所造成的负面影响也是极其巨大的。 最简单而直接的一个例子就是公共场合大喊大叫的现象了,可能是深受旅游团的影响,到哪都像拿着一个大喇叭在说话一样。 第二点还是上面所说的公共场合大吵大闹的事情。 就拿一个最简单的排队来说吧,也会出现许多插队的人,而且还是理直气壮的,这一点真的很让人来气了。 由此可见,部分国人的素质还是有待提高的。 前天听了网红资深律界红人罗翔老师的脱口秀 他说法律是给没有道德底线的人用的 普通人根本用不到 如果某人说他自己遵纪守法 那么说明他是个人渣 深以为然 有个朋友去新加坡留学了 就百度了下新加坡 新加坡大部分人都会说中文 而且环境极好 是中国人出境游首选 新马泰,新加坡排第一 法律严到什么地步呢? 抽烟的,在街上画了一个圈 只能站在圈内 哪怕你踩线的,身子大半都在圈内 不行,罚款!!! 随手扔垃圾? 罚款!!! 罚几次你还不听? 拿鞭子抽!! 是的,新加坡还保留着鞭刑! 早上等公交车时,车站几个在哪抽烟的 我还特意百度了下,什么叫公众场合 所谓的公众场合 出了家门,就叫公众场合!!!!!!!!!!!!!!!!!!!!!!! 上述两则外出公众场合大声喧哗,随地抽烟的恶习到底什么时候才会改? 这已经不能叫陋习了,说恶习都是比较光鲜靓丽的词 真是没教养的东西

中国游客7宗罪,全球最不受欢迎游客 中国游客7宗罪,全球最不受欢迎游客 ( [转载](https://baijiahao.baidu.com/s?id=1668567385573733394&wfr=spider&for=pc) )  上个月,《纽约时报》把中国游客列为"全球最不受欢迎游客"。 认为他们无论到哪里旅游都令人感到生厌,获得如此污名,原来说中国游客犯了七宗罪。 爱插队 不少中国游客多不爱排队,明明人人都在排队时,却有意无意插队。 沒文化 在欧洲旅游时,中国游客很多都不懂艺术,有些还像女性雕像前摆出不雅动作拍照。 高谈阔论 不少中国游客不理他人感受,何时何地都在高谈阔论。 怕吃亏 中国人怕吃亏,例如外游时坐公车,都会及时抢占座位。 自私 中国游客出外旅游,大多只顾自己感受,没有入乡随俗,不爱理会当地人的规矩。 到此一游 虽然自己不是名人,但都爱把自己名字写上名胜古迹处。 呕心行为 中国游客爱四处随地吐痰,随地大小便行为,非常不文明。 有游客在卢浮宫外泡脚。 转载2 [转载2 ](https://baijiahao.baidu.com/s?id=1615362296392771712&wfr=spider&for=pc) 为何如此讨厌中国游客?背后原因发人深省!网友:说的在理! 随着社会的发展,越来越多的人感慨生活节奏太快,压力太大活得很累。 在这种情况下,出去休闲放松一下就成了一个很好的解决方法。 在近些年里,中国的旅游业发展迅速,尤其是出国旅游的人数明显上升,中国游客由于各种原因在世界上“出名”了。 出名主要有两大原因。 第一,中国游客的人数基数大,购买力强,经常能带动当地经济的发展。 但同样的,由于形形色色什么样的人都有,游客的素质层次不齐,所以也就造成了一些国家地方对国人的印象很差,甚至有些警示标语采用中英两种翻译,目的是显而易见的。 经过一系列的事件以后,有一些国家在民间甚至都表示不愿意招待中国游客。 尽管他们能给当地带来很多经济收入,但所造成的负面影响也是极其巨大的。 最简单而直接的一个例子就是公共场合大喊大叫的现象了,可能是深受旅游团的影响,到哪都像拿着一个大喇叭在说话一样。 第二点还是上面所说的公共场合大吵大闹的事情。 就拿一个最简单的排队来说吧,也会出现许多插队的人,而且还是理直气壮的,这一点真的很让人来气了。 由此可见,部分国人的素质还是有待提高的。 前天听了网红资深律界红人罗翔老师的脱口秀 他说法律是给没有道德底线的人用的 普通人根本用不到 如果某人说他自己遵纪守法 那么说明他是个人渣 深以为然 有个朋友去新加坡留学了 就百度了下新加坡 新加坡大部分人都会说中文 而且环境极好 是中国人出境游首选 新马泰,新加坡排第一 法律严到什么地步呢? 抽烟的,在街上画了一个圈 只能站在圈内 哪怕你踩线的,身子大半都在圈内 不行,罚款!!! 随手扔垃圾? 罚款!!! 罚几次你还不听? 拿鞭子抽!! 是的,新加坡还保留着鞭刑! 早上等公交车时,车站几个在哪抽烟的 我还特意百度了下,什么叫公众场合 所谓的公众场合 出了家门,就叫公众场合!!!!!!!!!!!!!!!!!!!!!!! 上述两则外出公众场合大声喧哗,随地抽烟的恶习到底什么时候才会改? 这已经不能叫陋习了,说恶习都是比较光鲜靓丽的词 真是没教养的东西 -

活着真累 上中学时,我们化学老师很有意思 一次化学课时,有个同学趴桌子睡着了 他后面的同学戳了他一下,被老师看见了 老师就罚他立正 他辩解,说是前面的同学睡觉 是不是老师搞错了 老师说 人家睡的好好的 又没打搅到其他人听课 你为什么要打搅他睡觉? 老师是有大智慧的 师父领进门,修行在个人 学不学在你 但是你不要打搅到其他人 这不是在你家 要有边界感 做个文明人 小日本的手机一向声音不大 以听得见为准 大街小巷公众场合接打电话也是尽可能小声 以免打搅到其他人 国内就不一样了 生怕你不知道他买的起手机 有多大声就开多大声 特别是电梯里 极小的封闭空间 大声打电话 大声高谈阔论 旁若无人的吃喝 还有地铁上外放 快餐店里的各种杀猪声 我真是受够了 活着真累 活着真累 活着真累

活着真累 上中学时,我们化学老师很有意思 一次化学课时,有个同学趴桌子睡着了 他后面的同学戳了他一下,被老师看见了 老师就罚他立正 他辩解,说是前面的同学睡觉 是不是老师搞错了 老师说 人家睡的好好的 又没打搅到其他人听课 你为什么要打搅他睡觉? 老师是有大智慧的 师父领进门,修行在个人 学不学在你 但是你不要打搅到其他人 这不是在你家 要有边界感 做个文明人 小日本的手机一向声音不大 以听得见为准 大街小巷公众场合接打电话也是尽可能小声 以免打搅到其他人 国内就不一样了 生怕你不知道他买的起手机 有多大声就开多大声 特别是电梯里 极小的封闭空间 大声打电话 大声高谈阔论 旁若无人的吃喝 还有地铁上外放 快餐店里的各种杀猪声 我真是受够了 活着真累 活着真累 活着真累  -

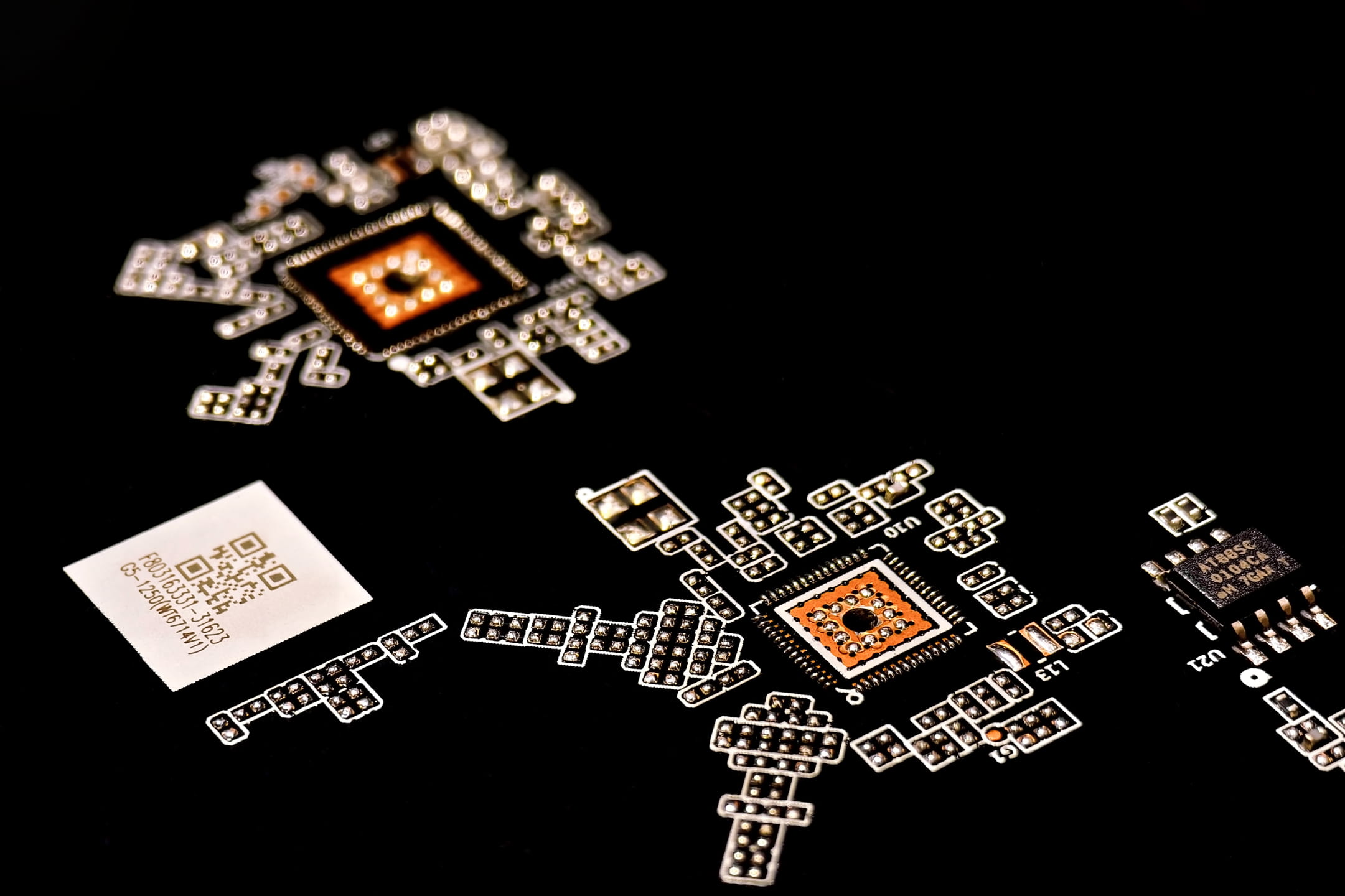

老板的信 老板是一个爱分享的人 今天公司给我们发礼物了 老板是狮子会的会员 上次他去云南参加狮友换届时 带了些月饼回来分给大家 大家都觉得不错 这次又买了些,给大多老员工发了 我也领到了一箱 还附带了一封信  信看完了 感触良多 我思维比较发散 以下想到什么说什么 老板为人随和 没有架子 待我极好 老板的家人也待我极好 回想起来,我大概是我们公司所有人里面在老板家以及跟老板一起吃饭最多的那个人 我在这家公司待了十年了 中途有出去过一次 回家后想在家里做点什么为生 但是也没找到什么合适的 就又出来了 今天是黑暗神话悟空的正式开启日 虽然我没有经历过悟空那九九八十一难 什么画饼,欠薪,甚至于这期间那黑心老板的机票钱,至今都没给我...... 走走停停经历了不少磨难 终又回到了这家公司 我没有创过业 村里人说了 什么虫蛀什么木 不是那块料 很多人看到的是老板开豪车 想什么时候来上班就什么时候来上班 老板在深圳有几套房 老板孩子读好学校等等等等 但是没有人站在老板位置想想 老板真的那么风光吗? 三年疫情困难时期 员工大不了提桶走路奔下一家 老板能随便提桶吗? 老板手底下近200号人 梁山好汉也不过108人 如果产线做了次品出来 做错的那个人依然继续朝九晚五即可 老板得星夜兼程赶去客户那里 低头哈腰昧着良心说好话 车间随便一台机器几万十几万几十万的 那不是天上掉下来的 每个月200号人的工资要多少钱 每个月的租金要多少钱 每个月的电费又要多少钱 每个月设备的折损多少钱 当产线机器空闲没有订单时 当订单来了产线赶不出货时 当同事因疫情被隔离时 没有人在意过 大家只看到了悟空出世卖了4个亿 没有人看见研发悟空6年时间是没有进账的 能力越大,责任越大 老板这些年不容易 四十出头的年纪 看起来快六十了 哈哈哈 夸张了 头发已经花白了 皱纹也明显了 身体问题也越发多了 哎 希望大家都好吧

老板的信 老板是一个爱分享的人 今天公司给我们发礼物了 老板是狮子会的会员 上次他去云南参加狮友换届时 带了些月饼回来分给大家 大家都觉得不错 这次又买了些,给大多老员工发了 我也领到了一箱 还附带了一封信  信看完了 感触良多 我思维比较发散 以下想到什么说什么 老板为人随和 没有架子 待我极好 老板的家人也待我极好 回想起来,我大概是我们公司所有人里面在老板家以及跟老板一起吃饭最多的那个人 我在这家公司待了十年了 中途有出去过一次 回家后想在家里做点什么为生 但是也没找到什么合适的 就又出来了 今天是黑暗神话悟空的正式开启日 虽然我没有经历过悟空那九九八十一难 什么画饼,欠薪,甚至于这期间那黑心老板的机票钱,至今都没给我...... 走走停停经历了不少磨难 终又回到了这家公司 我没有创过业 村里人说了 什么虫蛀什么木 不是那块料 很多人看到的是老板开豪车 想什么时候来上班就什么时候来上班 老板在深圳有几套房 老板孩子读好学校等等等等 但是没有人站在老板位置想想 老板真的那么风光吗? 三年疫情困难时期 员工大不了提桶走路奔下一家 老板能随便提桶吗? 老板手底下近200号人 梁山好汉也不过108人 如果产线做了次品出来 做错的那个人依然继续朝九晚五即可 老板得星夜兼程赶去客户那里 低头哈腰昧着良心说好话 车间随便一台机器几万十几万几十万的 那不是天上掉下来的 每个月200号人的工资要多少钱 每个月的租金要多少钱 每个月的电费又要多少钱 每个月设备的折损多少钱 当产线机器空闲没有订单时 当订单来了产线赶不出货时 当同事因疫情被隔离时 没有人在意过 大家只看到了悟空出世卖了4个亿 没有人看见研发悟空6年时间是没有进账的 能力越大,责任越大 老板这些年不容易 四十出头的年纪 看起来快六十了 哈哈哈 夸张了 头发已经花白了 皱纹也明显了 身体问题也越发多了 哎 希望大家都好吧 -

-

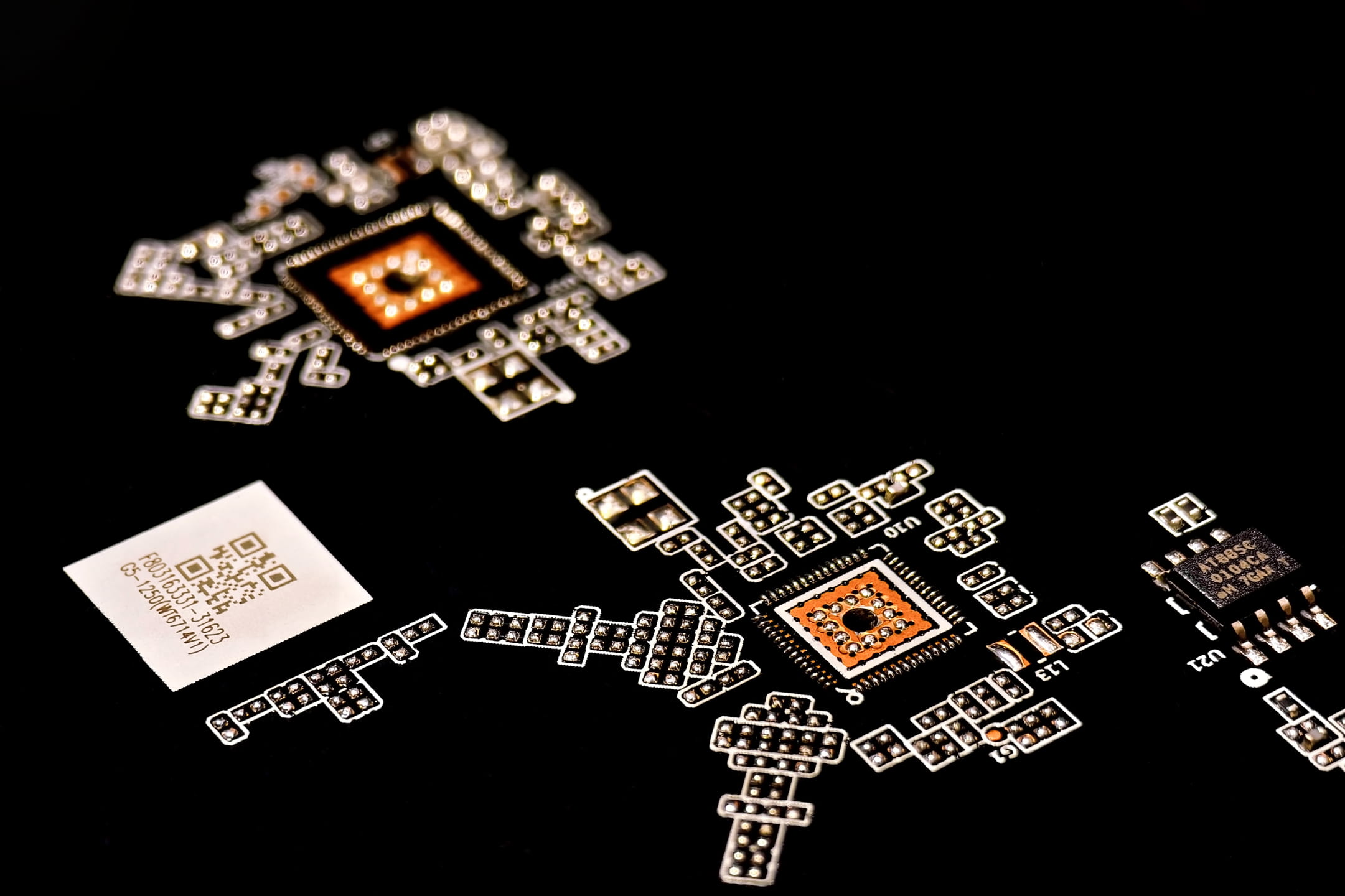

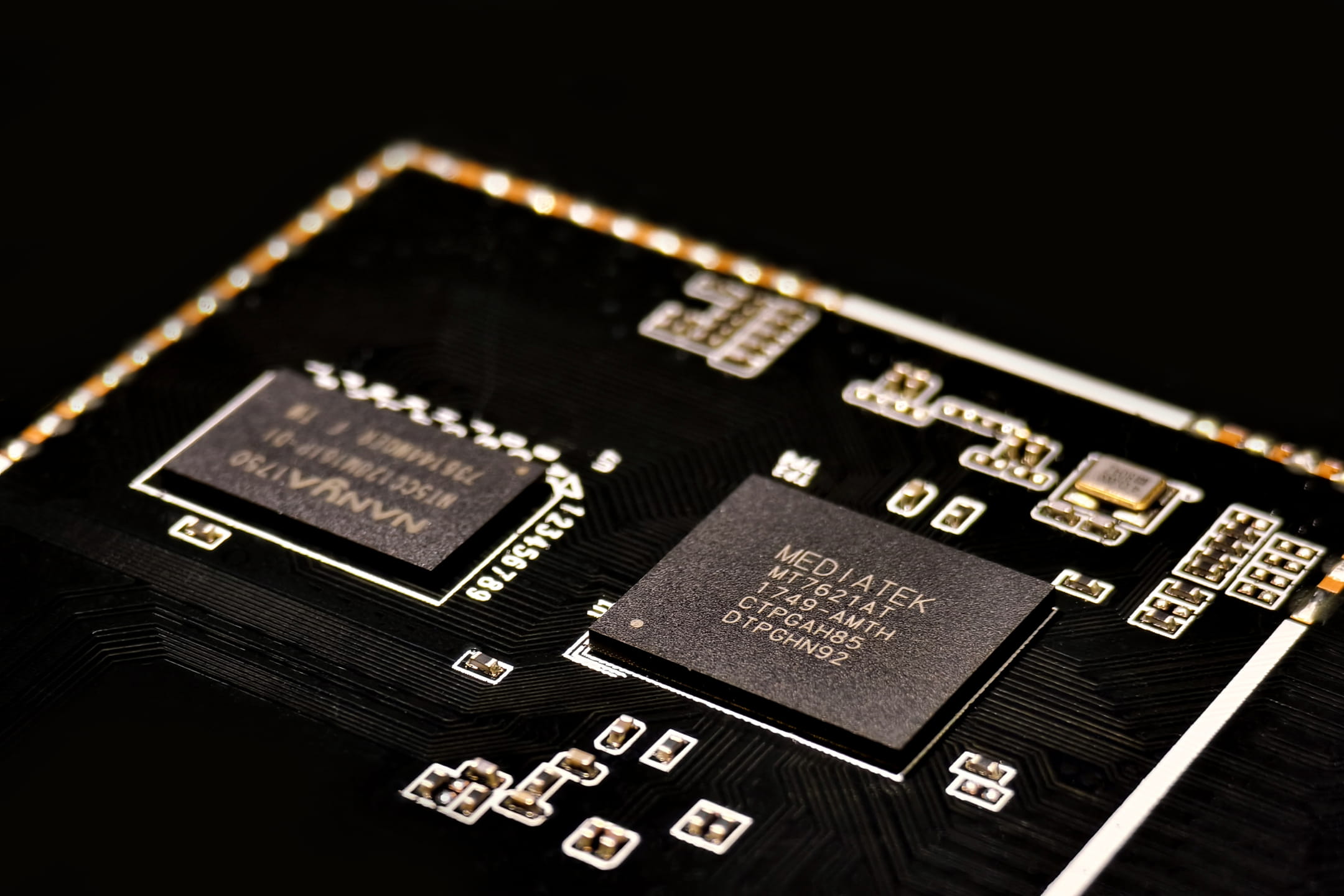

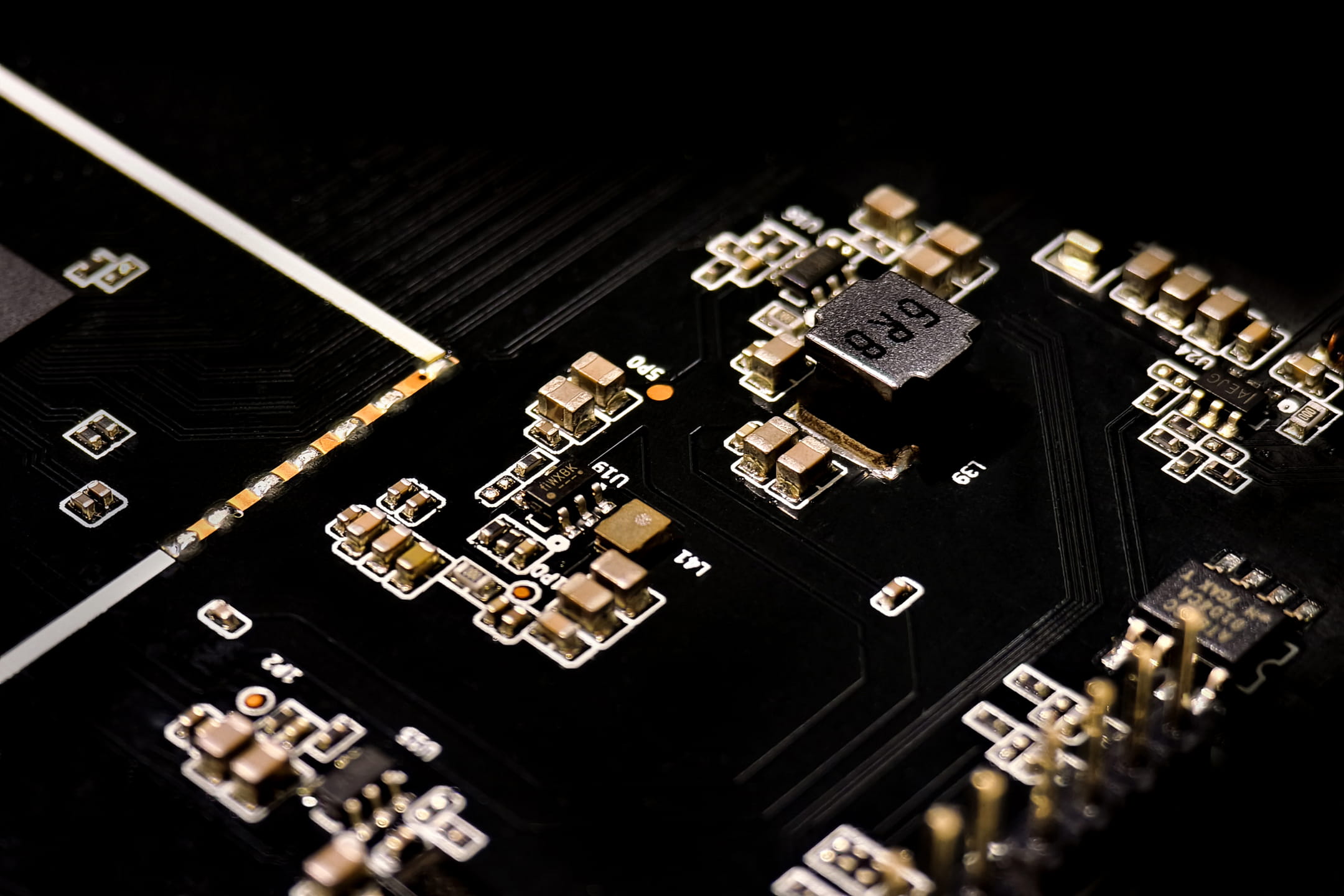

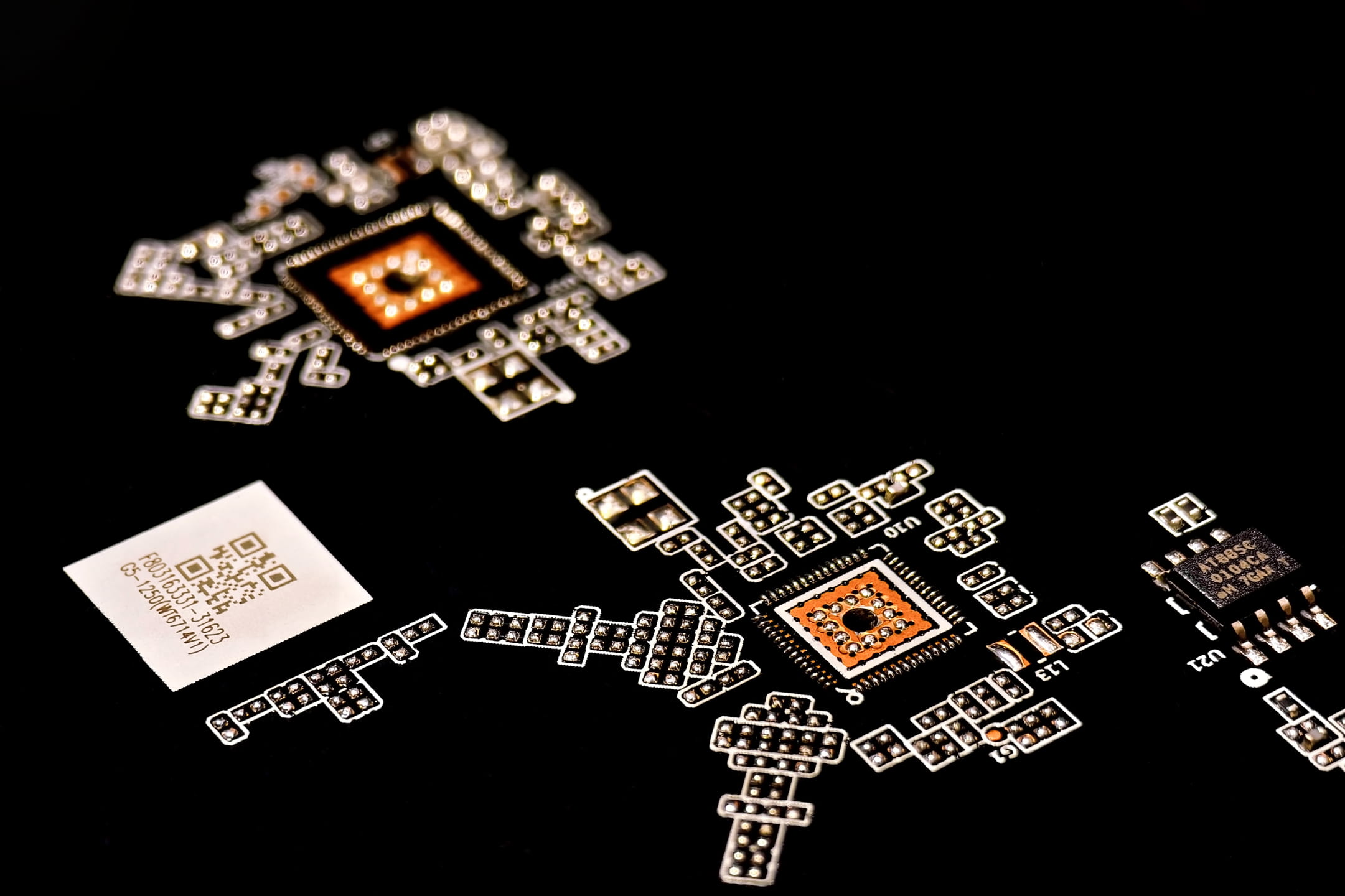

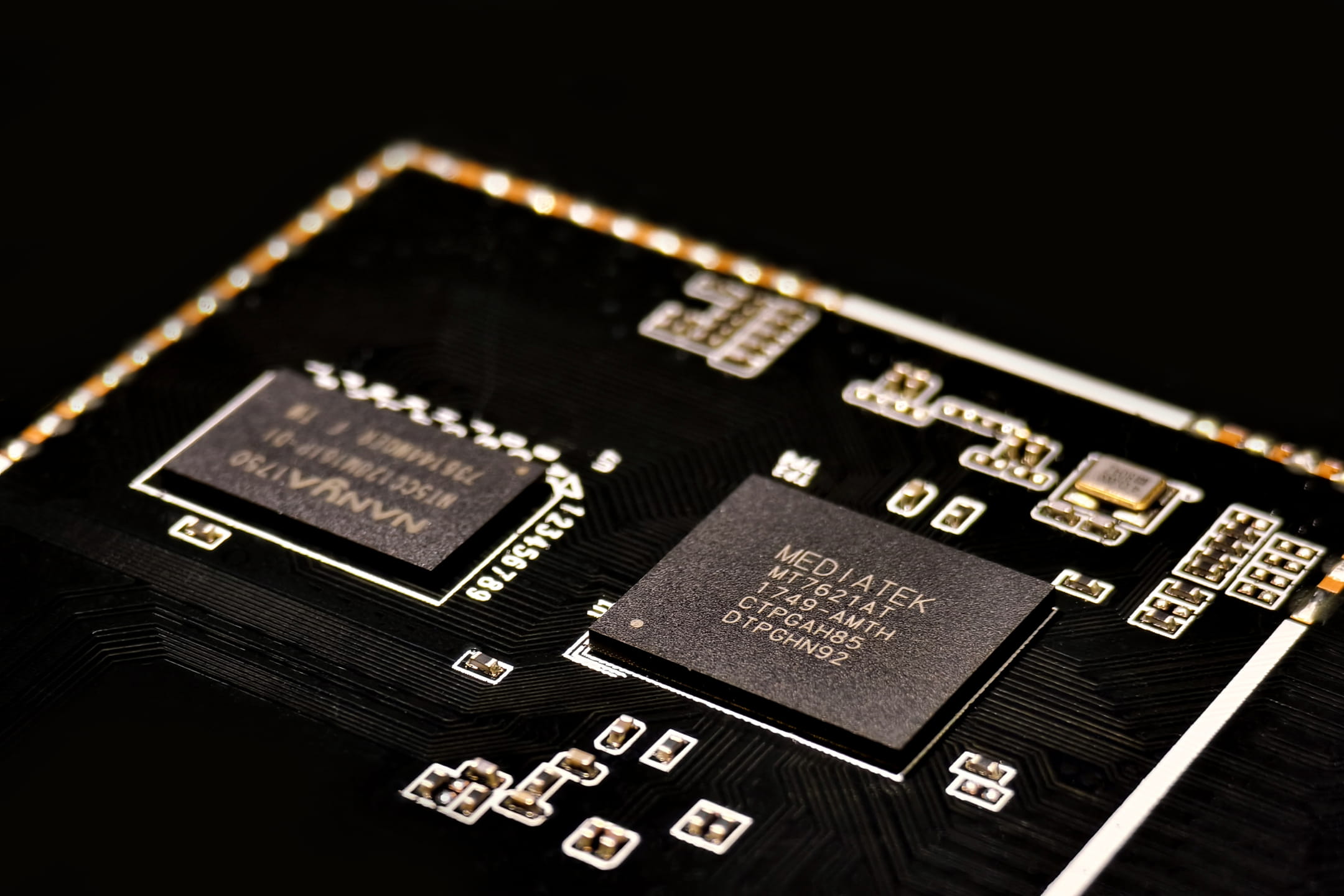

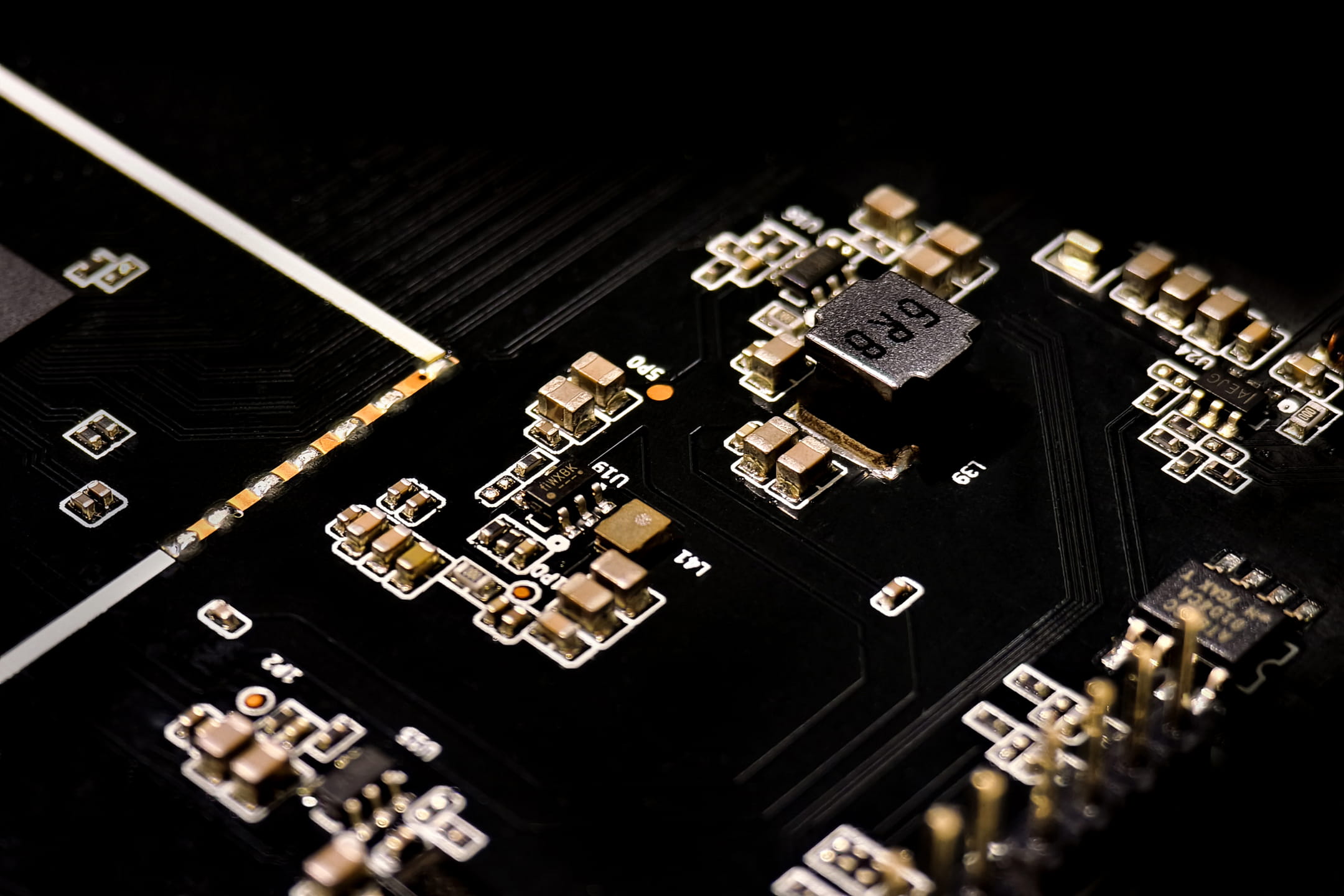

贝锐蒲公英路由器那些反人类的设计吐槽 贝锐蒲公英路由器那些反人类的设计吐槽 1 想方设法搞钱是第一要务,不交钱什么端口随机,等等各种让你不爽 2 系统及其不稳定,经常掉线 4 IP地址排序,提了两年多了,至今没有解决 5 旧版系统在线设备名称可以中文命名,升级后给关掉了,只能英文命名,负优化做的极好!!!!!!!!!!!!! 6 实时流量信息就是哄你玩的,随便给你几个数字告诉你我有这功能啊 7 同型号,新路由器不能导入旧路由器的备份,导致旧路由器所有设置全部作废 8 MAC地址大写和小写在这个系统算两个东西,换机配置导出不能用,我用了第三方工具,导出了MAC黑名单,全小写。等我一个个输入到路由器黑名单时,发现设置了黑名单还能上网,然后全部重新再设置一次,操蛋真他妈的操蛋!!!!!!!!!! 9 为了让用户用云端,就连MAC地址白名单黑名单功能都必须在云端设置 上周因为旧款频繁掉线已经换到第五个了 买了双wan口的 设置了mac白名单,全都上不了网 你猜结果咋的? 白名单需要在云端设置,路由器本地没有这个功能 我不能上网了,怎么设置? 这系统工程师是有多脑残啊? 脑残片吃多了吗??????????

贝锐蒲公英路由器那些反人类的设计吐槽 贝锐蒲公英路由器那些反人类的设计吐槽 1 想方设法搞钱是第一要务,不交钱什么端口随机,等等各种让你不爽 2 系统及其不稳定,经常掉线 4 IP地址排序,提了两年多了,至今没有解决 5 旧版系统在线设备名称可以中文命名,升级后给关掉了,只能英文命名,负优化做的极好!!!!!!!!!!!!! 6 实时流量信息就是哄你玩的,随便给你几个数字告诉你我有这功能啊 7 同型号,新路由器不能导入旧路由器的备份,导致旧路由器所有设置全部作废 8 MAC地址大写和小写在这个系统算两个东西,换机配置导出不能用,我用了第三方工具,导出了MAC黑名单,全小写。等我一个个输入到路由器黑名单时,发现设置了黑名单还能上网,然后全部重新再设置一次,操蛋真他妈的操蛋!!!!!!!!!! 9 为了让用户用云端,就连MAC地址白名单黑名单功能都必须在云端设置 上周因为旧款频繁掉线已经换到第五个了 买了双wan口的 设置了mac白名单,全都上不了网 你猜结果咋的? 白名单需要在云端设置,路由器本地没有这个功能 我不能上网了,怎么设置? 这系统工程师是有多脑残啊? 脑残片吃多了吗??????????      -